Zum Experiment

In dieser zweiten Versuchsreihe vertiefen wir unsere Untersuchung zur 3D-Rekonstruktion mittels Gaussian Splatting. Aufbauend auf dem ersten Experiment erweitern wir die Methodik um systematisches Pre-Processing und unterschiedlich große Bilddatensätze. Ziel ist es, die Auswirkungen der Bildauswahl, Bildanzahl und Alignment-Verfahren auf die Qualität und Effizienz der resultierenden Splats zu evaluieren.

Interaktiver Demonstrator

Zur Veranschaulichung der Ergebnisse wurde ein interaktiver Web-Demonstrator mit PlayCanvas umgesetzt. Dieser erlaubt es Nutzer:innen, die generierten Gaussian Splats direkt im Browser zu betrachten und miteinander zu vergleichen.

Besondere Funktionen des Demonstrators:

- Animierter Übergang zwischen Splats verschiedener Jahre: Nutzer:innen können stufenlos zwischen Rekonstruktionen unterschiedlicher Zeitpunkte wechseln und so bauliche Veränderungen oder den Einfluss von Witterung und Vegetation visuell nachvollziehen. Am Beispiel des Fördergerüsts ist z. B. die zwischen Sommer 2023 bis 2025 durchgeführte Restaurierung erfasst.

- Tag-Nacht-Wechsel: Durch eine einfache Lichtsimulation wird der Wechsel zwischen Tag- und Nachtbeleuchtung ermöglicht, um das räumliche Erscheinungsbild unter unterschiedlichen Lichtbedingungen zu demonstrieren.

- Relightable Gaussian Splatting (experimentell): Erste Tests mit einem einfachen, initialen Ansatz zur lichtdynamischen Darstellung wurden integriert. Dieser erlaubt eine rudimentäre Lichtinteraktion innerhalb der Splats und bildet die Grundlage für weiterführende Arbeiten an realistischeren Lichtmodellen in zukünftigen Versionen.

Datengrundlage

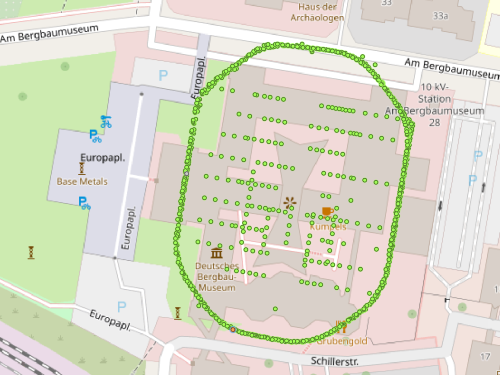

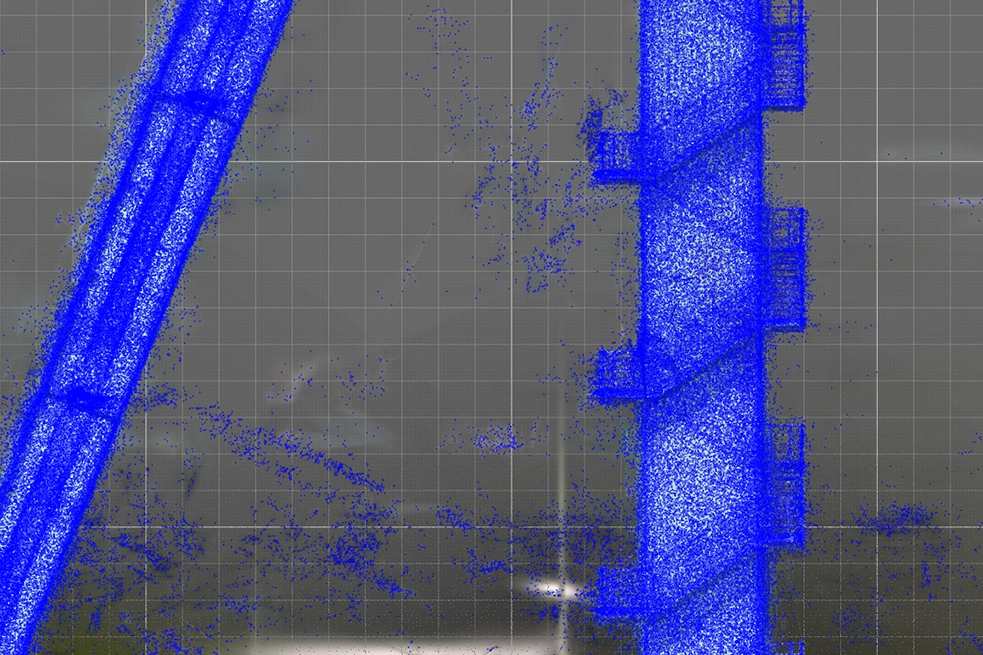

Für dieses Experiment wurden 1.909 Drohnenaufnahmen mit einer Auflösung von 5280 × 3956 Pixeln aufgenommen. Der Datensatz setzt sich aus vier Aufnahmeserien zusammen: aus Orbitalflügen, bei denen die Drohne in mehreren Höhenstufen kreisförmig um das Fördergerüst geflogen ist, aus einer Top-Down-Serie, bei der das Fördergerüst senkrecht von oben erfasst wurde. Zusätzlich wurden zwei vertikale Flüge, bei denen die Drohne die beiden Innenhöfe an jeweils zwei Punkten durch Drehung um die eigene Achse erfasst hat, durchgeführt (die in diesem Experiment aber noch nicht verwertet wurden).

Die Bilder wurden zunächst auf 3450 × 3000 Pixel zugeschnitten (Cropping), um Vignettierungen und Randunschärfen zu entfernen. Anschließend wurde der Datensatz mithilfe automatischer Schärfemessung und manueller Bewertung auf 1.247 qualitativ hochwertige Bilder reduziert.

Es wurden zunächst drei verschiedene Imagesets erzeugt:

- Best100 – Auswahl der 100 schärfsten Bilder

- Best500 – Auswahl der 500 schärfsten Bilder

- All – Alle 1.247 Bilder

Einfluss der Bildanzahl auf die Rekonstruktionsqualität

Ein zentraler Aspekt der Versuchsreihe war die Untersuchung des Zusammenhangs zwischen der Anzahl verwendeter Bilder und der Qualität der resultierenden 3D-Rekonstruktion. Dazu wurde ein mit PlayCanvas umgesetzter Demonstrator erstellt, der einen direkten visuellen Vergleich zwischen den Splats der Datensätze ermöglicht.

Der Demonstrator zeigt deutlich: Bereits mit 100 sorgfältig ausgewählten Bildern lassen sich ansprechende Modelle erzeugen. Mit zunehmender Bildanzahl steigt jedoch die Dichte und Detailtreue der Rekonstruktion spürbar an – insbesondere bei manueller Ausrichtung. Gleichzeitig wachsen aber auch Rechenaufwand und Trainingszeit. Der interaktive Vergleich bietet eine anschauliche Grundlage für Abwägungen zwischen Datenmenge, Qualität und Verarbeitungskosten bei zukünftigen Projekten.

Vergleich der Rekonstruktionsqualität

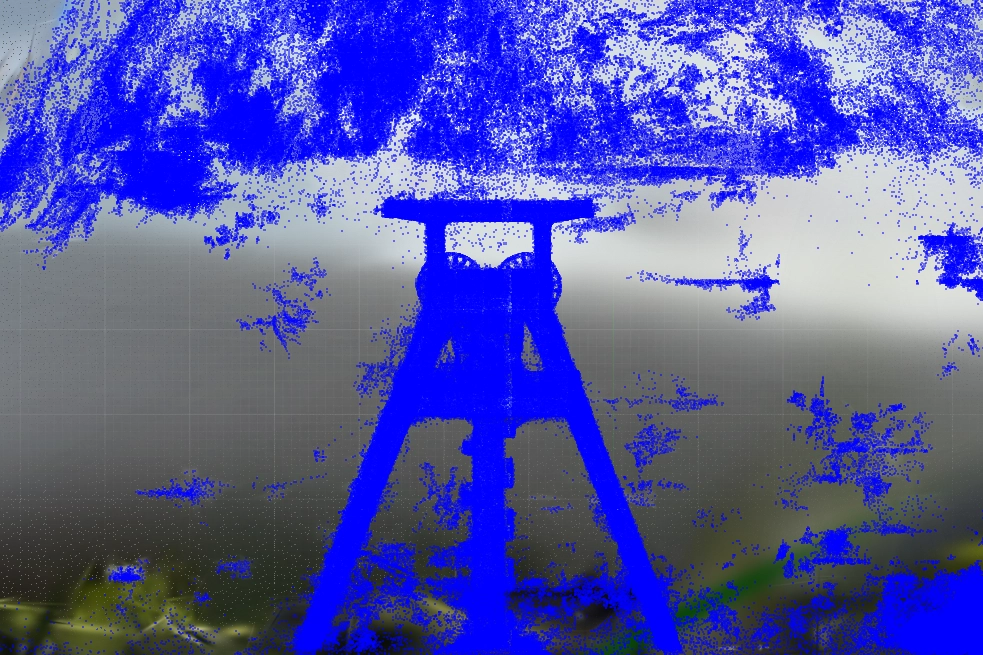

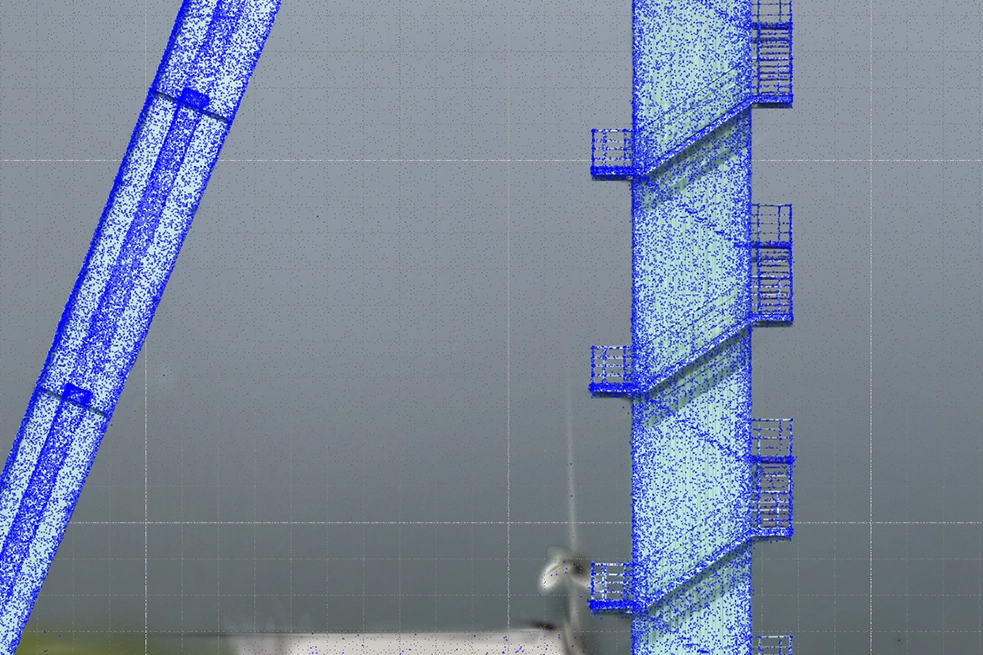

Ein Vergleich der Rekonstruktionen zeigt deutliche Unterschiede in der Qualität und Sauberkeit der Ergebnisse. Bei der Verwendung von nur 100 oder 500 Bildern treten insbesondere im Bereich des Himmels und an den Kanten des Objekts zahlreiche Floater auf – also Splats, die nicht zur eigentlichen Struktur des Fördergerüsts gehören, sondern als Rauschen erscheinen. Diese Artefakte erfordern teils aufwändige manuelle Nachbearbeitung, etwa durch gezieltes Entfernen in PlayCanvas.

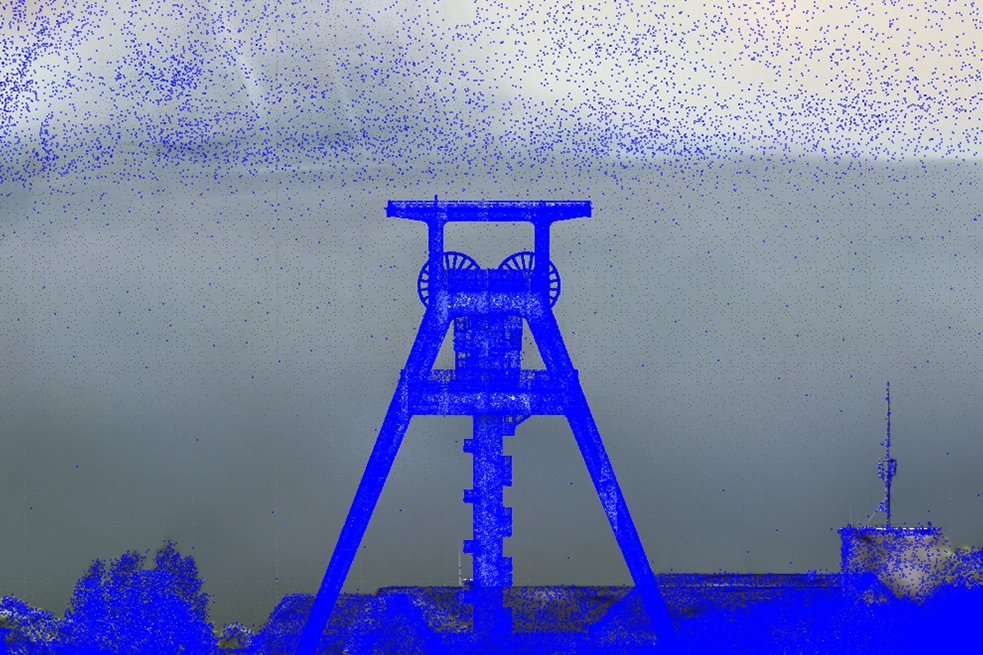

Demgegenüber bietet das vollständige Set aus 1.247 Bildern eine deutlich höhere Dichte und Präzision der Rekonstruktion: Floater treten nur vereinzelt auf, und die Szene ist insgesamt wesentlich besser ausdifferenziert. Zwar verlängert sich durch die größere Datenmenge die Trainingszeit erheblich, doch wird dieser Aufwand durch eine deutlich reduzierte Nachbearbeitungszeit kompensiert. Der Trade-off zwischen Rechenzeit und manuellem Aufwand ist damit ein zentrales Kriterium bei der Wahl des geeigneten Bildumfangs.

Verwendete Tools & Workflow

Input Processing

- Adobe Bridge: Zur Auswahl, Bewertung und Bearbeitung der Bilder (Weißabgleich, Zuschneiden, etc.)

- Sharp Frames: Automatisierte Bildauswahl und Entfernung von Ausreißern basierend auf der Bildschärfe

Pre-Processing

- RealityScan: Für das Alignment der Bilder je nach Imageset zunächst automatisch. Zusätzliche automatisierte Ausrichtung der Die manuelle Ausrichtung wurde insbesondere bei den vollständigen Datensätzen durchgeführt, um die Orbit- und Top-Down-Aufnahmen besser zu kombinieren.

Training und Rekonstruktion

Postshot: Verwendet für das Training der Gaussian Splats.

Für jedes Imageset wurden maximal 3 Millionen Splats mit 30.000 (bzw. 125.000 bei vollständigen Datensätzen) Trainingsschritten erzeugt.

Verwendeter Algorithmus: Vergleichend zwischen Splat3 und MCMC

Trainingsdauer: etwa 7 Stunden pro vollständigem Datensatz, Best 100 und Best 500 deutlich kürzer.

Post-Processing

- Self-Organizing Gaussian Splatting (SOGS): Verlustbehaftete Komprimierung zur Reduktion der Dateigröße um den Faktor ~20 (z. B. von ~800 MB auf 30–40 MB), bei gleichzeitig kaum sichtbarem Qualitätsverlust. Hier experimentell mittels Python Package umgesetzt. Im Demonstrator kommen aktuell noch .ply zum Einsatz.

- SuperSplat Editor: Zur Inspektion, Bereinigung und weiteren Reduktion der 3D-Rekonstruktionen.

- PlayCanvas Engine: Programmierung des interaktiven Demonstrators

Ergebnisse & Fazit

Die Versuchsreihe bestätigt die hohe Relevanz von gezieltem Pre-Processing für die Qualität der resultierenden 3D-Splats. Besonders das manuelle Alignment sowie die gezielte Reduktion der Eingabebilder auf besonders scharfe und relevante Aufnahmen führten zu signifikant besseren Resultaten. Auch der Einfluss der Bildanzahl war sichtbar: Während das „Best100“-Set sehr effizient zu handhaben war, ergaben die vollständigen Datensätze mit manuellem Alignment Rekonstruktionen, die der Realität am nächsten kamen.

Aufbauend auf diesen Ergebnissen werden in anstehenden Experimenten die Auswirkungen der Punktwolkendichte auf die Trainingsergebnisse systematischer untersucht. Ein vielversprechender Weg ist der Vergleich zwischen dem Training von Splats direkt aus reduzierten Sparse Point Clouds und dem Training mit dichteren Punktwolken und der Anwendung von Sparsification während des Post-Processings. Dies würde ein genaueres Verständnis dafür ermöglichen, wo und wie die Rekonstruktionsqualität erhalten oder sogar verbessert werden kann, während gleichzeitig die Rechenressourcen optimiert werden. Darüber hinaus könnten solche vergleichenden Studien dazu beitragen, Best-Practice-Richtlinien für die Ausgewogenheit von Vorverarbeitungsaufwand, Datenvolumen und Rekonstruktionsgenauigkeit in praktischen Anwendungen zu entwickeln.